UbuntuでTensorFlow使用環境を構成する方法

1.TensorFlowの概要

TensorFlow™は、データフロープログラミングに基づくシンボリック数学システムであり、さまざまな機械学習アルゴリズムのプログラミングで広く使用されています。その前身は、GoogleのニューラルネットワークアルゴリズムライブラリDistBeliefです。

Tensorflowは、さまざまなサーバー、PC端末、Webページに展開できるマルチレベルの構造を持ち、[GPU](https://cloud.tencent.com/product/gpu?from=10680)とTPUの高性能数値コンピューティングをサポートします。Googleの社内製品開発やさまざまな分野の科学研究で広く使用されています。

TensorFlowは、Google人工知能チームであるGoogle Brainによって開発および保守されており、TensorFlow Hub、TensorFlow Lite、TensorFlow Research Cloud、さまざまなアプリケーションプログラミングインターフェイス(API)などの複数のプロジェクトがあります。 2015年11月9日以降、TensorFlowはApache2.0オープンソースライセンスの下でソースコードをオープンしました。

2、Anacondaをインストールします

Anacondaは、condaやPythonなどの180を超える科学パッケージとそれらの依存関係を含むオープンソースのPythonディストリビューションを指します。多数の科学パッケージが含まれているため、Anacondaのダウンロードファイルは比較的大きくなります(約531 MB)。特定のパッケージのみが必要な場合、または帯域幅やストレージスペースを節約する必要がある場合は、より小さなリリースバージョンのMinicondaを使用することもできます(condaとPython)。

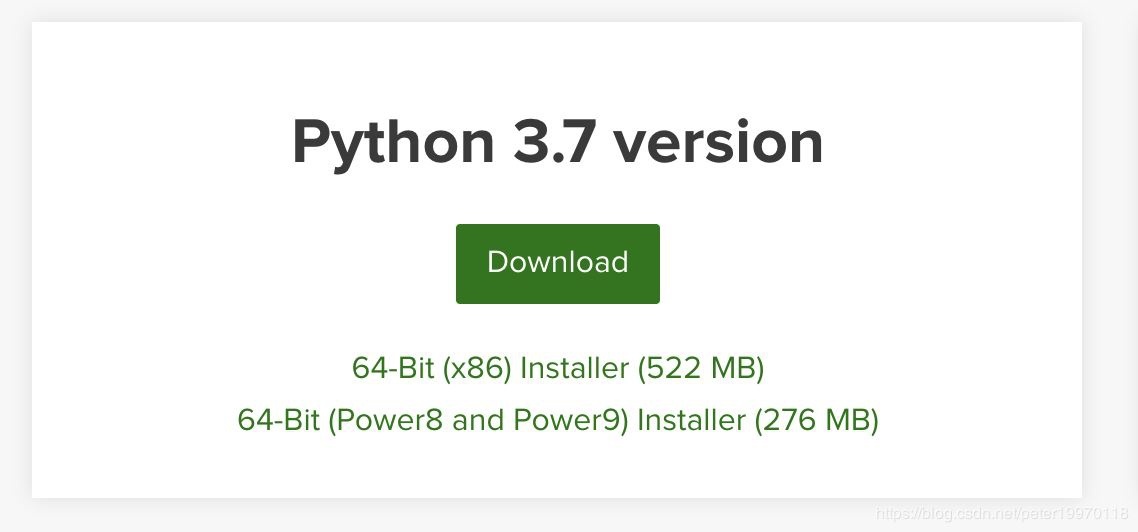

アナコンダを入手

公式サイトのダウンロードリンクからPython3.7のインストールパッケージをダウンロードしてください

ダウンロードしたファイルは Anaconda3-2020.02-Linux-x86_64.shです。

インストールを開始します

ターミナルを使用してAnacondaファイルが保存されているディレクトリに入り、次のコマンドを使用してインストールを開始します

bash Anaconda3-2020.02-Linux-x86_64.sh

インストール開始後、アナコンダライセンスを確認します。スキップする場合は、Qを押してスキップします。その後、同意するかどうかを確認し(ライセンス条項を承認しますか?)、「はい」と入力し、Enterキーを押して続行します。

次に、Anacondaをインストールするパスを尋ねられます。指定されている場合は、パスを入力し、Enterキーを押して続行します。指定されていない場合は、デフォルトのホームディレクトリにインストールされ、Enterキーを押して続行します。

次のプロンプトが確認されたら、〜/ .bashrcファイルに環境変数を追加するかどうかを確認し、「yes」と入力して続行します。スクロールが終了すると、Anacondaのインストールが完了します。

**3、TensorFlow **の2つの主要な依存関係パッケージ

Protocol Buffer

まず、apt-getを使用して必要なコンポーネントをインストールします

$ sudo apt-get install autoconf automake libtool curl make g++ unzip

次に、適切なディレクトリにcdし、gitclone関数を使用してインストールファイルを取得します

$ git clone

$ https://github.com/protocolbuffers/protobuf.git

$ cd protobuf

$ git submodule update --init --recursive

$ ./autogen.sh

インストールを開始します

$ ./configure

$ make

$ make check

$ sudo make install

$ sudo ldconfig # refresh shared library cache.

インストールが終了したら、次のコマンドを使用してバージョン番号を確認し、インストールが成功します

$ protoc --version

Bazel

インストールの準備

Bazelをインストールする前に、JDK8をインストールする必要があります。具体的なインストール方法については、次のリンクを参照してください。

jdk8のインストール方法

次に、他の依存関係キットをインストールします

$ sudo apt-get install pkg-config zip g++ zlib1g-dev unzip

Bazelを入手

リリースページで bazel-0.4.3-jdk7-installer-linux-x86_64.shを入手します。

次に、このインストールパッケージからBazelをインストールします

$ chmod +x bazel-0.4.3-jdk7-installer-linux-x86_64.sh

$ ./bazel-0.4.3-jdk7-installer-linux-x86_64.sh --user

インストールが完了したら、TensorFlowに必要な他の依存関係キットのインストールを続行します

$ sudo apt-get install python3-numpy swig python3-dev python3-wheel

完了後、〜/ .bashrcに環境変数を追加します

export PATH"$PATH:$HOME/bin"

次に、 $ source〜 / .bashrcを使用してアクティブ化します

次に、ターミナルに「bazel」と入力すると、バージョン番号が表示され、インストールが成功します。

**第四に、CUDAとcuDNN **をインストールします

NVIDIA GPUがコンピューターにインストールされ、ドライバーがインストールされている場合、GPUコンピューティングにCUDAとcuDNNを使用できます。

CUDA

CUDA(Compute Unified Device Architecture)は、グラフィックカードメーカーのNVIDIAが立ち上げたコンピューティングプラットフォームです。 CUDA™は、NVIDIAが立ち上げた汎用並列コンピューティングアーキテクチャであり、GPUが複雑なコンピューティングの問題を解決できるようにします。これには、CUDA命令セットアーキテクチャ(ISA)とGPU内の並列コンピューティングエンジンが含まれます。開発者はC言語を使用して、CUDA™アーキテクチャ用のプログラムを作成できます。C言語は、最も広く使用されている高レベルのプログラミング言語です。作成したプログラムは、CUDA™をサポートするプロセッサ上で超高性能で実行できます。 CUDA3.0はC ++とFORTRANのサポートを開始しました。

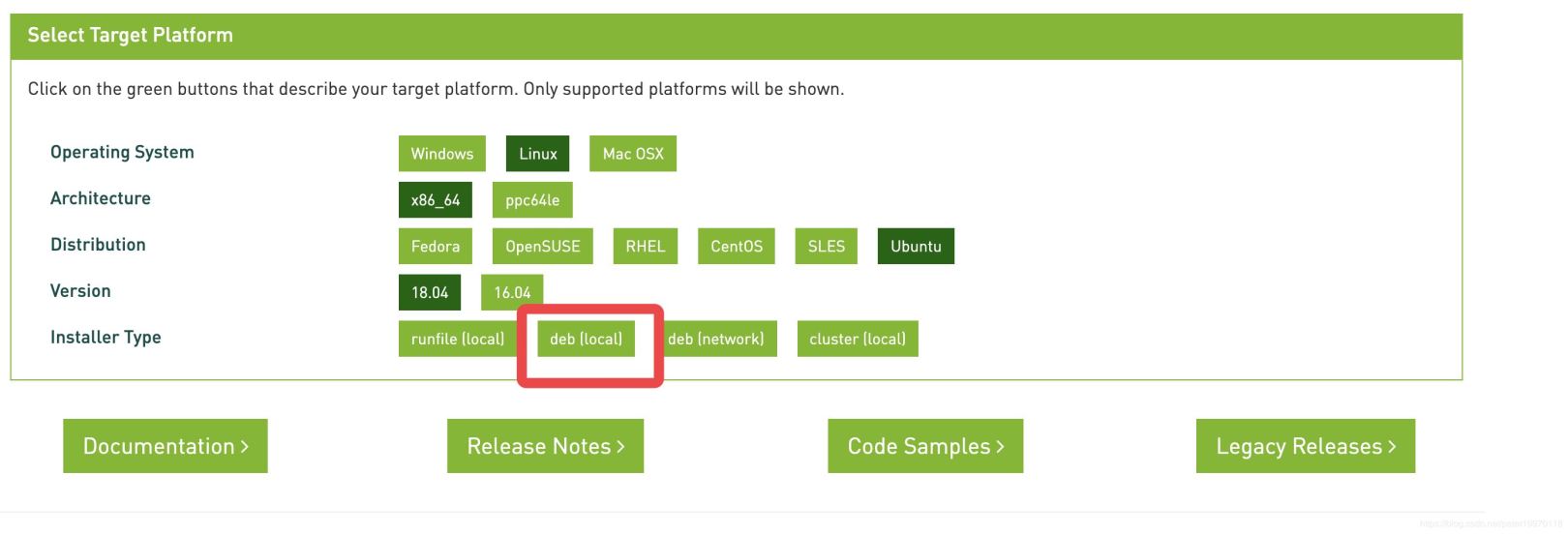

**CUDA **を入手してインストールします

公式ウェブサイトでCUDAツールキットインストールパッケージの適切なバージョンを入手してください

次のコマンドを使用してcudaをインストールします

$ wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu1804/x86_64/cuda-ubuntu1804.pin

$ sudo mv cuda-ubuntu1804.pin /etc/apt/preferences.d/cuda-repository-pin-600

$ wget http://developer.download.nvidia.com/compute/cuda/10.2/Prod/local_installers/cuda-repo-ubuntu1804-10-2-local-10.2.89-440.33.01_1.0-1_amd64.deb

$ sudo dpkg -i cuda-repo-ubuntu1804-10-2-local-10.2.89-440.33.01_1.0-1_amd64.deb

$ sudo apt-key add /var/cuda-repo-10-2-local-10.2.89-440.33.01/7fa2af80.pub

$ sudo apt-get update

$ sudo apt-get-y install cuda

CUDAをテストする

インストールが完了したら、インストールを確認するために、コンパイルするサンプルディレクトリを入力します

$ cd /usr/local/sample

$ make all

このとき、コンパイルエラーが発生している可能性があり、nvscibuf.hが見つからないというエラーメッセージが表示されます。geditツールを使用してMakefileファイルを開き、41行目を次のように変更します。

FILTER_OUT := 0_Simple/cudaNvSci/Makefile

次に、「すべてを作成」してコンパイルします。コンパイルが成功すると、「CUDAサンプルの構築が完了しました」というプロンプトが表示されます。

このとき、 / usr / local / cuda / extras / demo_suiteディレクトリに入り、 deviceQuery実行可能ファイルを見つけて実行すると、GPU関連の情報が出力されます。

これはブロガーのGPU情報です

CUDA Device Query(Runtime API)version(CUDART static linking)

Detected 1 CUDA Capable device(s)

Device 0:"GeForce GTX 1060 6GB"

CUDA Driver Version / Runtime Version 10.2/10.2

CUDA Capability Major/Minor version number:6.1

Total amount of global memory:6075MBytes(6370295808 bytes)(10) Multiprocessors,(128) CUDA Cores/MP:1280 CUDA Cores

GPU Max Clock rate:1759MHz(1.76 GHz)

Memory Clock rate:4004 Mhz

Memory Bus Width:192-bit

L2 Cache Size:1572864 bytes

Maximum Texture Dimension Size(x,y,z) 1D=(131072), 2D=(131072,65536), 3D=(16384,16384,16384)

Maximum Layered 1D Texture Size,(num) layers 1D=(32768),2048 layers

Maximum Layered 2D Texture Size,(num) layers 2D=(32768,32768),2048 layers

Total amount of constant memory:65536 bytes

Total amount of shared memory per block:49152 bytes

Total number of registers available per block:65536

Warp size:32

Maximum number of threads per multiprocessor:2048

Maximum number of threads per block:1024

Max dimension size of a thread block(x,y,z):(1024,1024,64)

Max dimension size of a grid size(x,y,z):(2147483647,65535,65535)

Maximum memory pitch:2147483647 bytes

Texture alignment:512 bytes

Concurrent copy and kernel execution: Yes with2 copy engine(s)

Run time limit on kernels: Yes

Integrated GPU sharing Host Memory: No

Support host page-locked memory mapping: Yes

Alignment requirement for Surfaces: Yes

Device has ECC support: Disabled

Device supports Unified Addressing(UVA): Yes

Device supports Compute Preemption: Yes

Supports Cooperative Kernel Launch: Yes

Supports MultiDevice Co-op Kernel Launch: Yes

Device PCI Domain ID / Bus ID / location ID:0/1/0

Compute Mode:<Default(multiple host threads can use ::cudaSetDevice()with device simultaneously)

deviceQuery, CUDA Driver = CUDART, CUDA Driver Version =10.2, CUDA Runtime Version =10.2, NumDevs =1, Device0 = GeForce GTX 1060 6GB

Result = PASS

この時点で、CUDAがインストールされます。

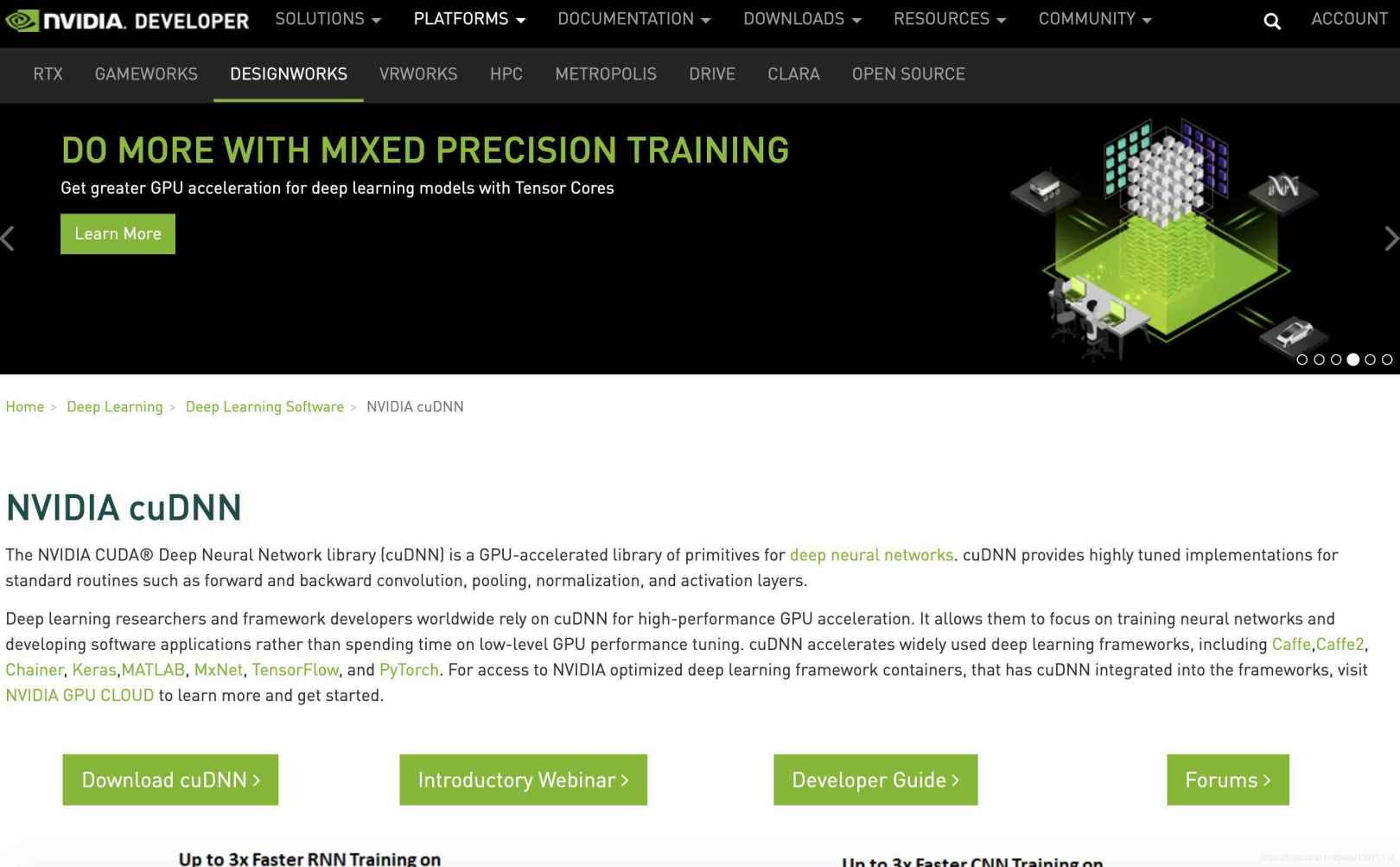

cuDNN(CUDAのインストールが完了した後にのみ使用可能)

NVIDIA cuDNNは、ディープニューラルネットワーク用のGPUアクセラレーションライブラリです。パフォーマンス、使いやすさ、メモリオーバーヘッドの低さを強調しています。 NVIDIA cuDNNは、カリフォルニア大学バークレー校の人気のカフェソフトウェアなど、より高レベルの機械学習フレームワークに統合できます。シンプルなプラグイン設計により、開発者はパフォーマンスを調整する代わりにニューラルネットワークモデルの設計と実装に集中でき、GPUでの高性能の最新の並列コンピューティングも可能になります。

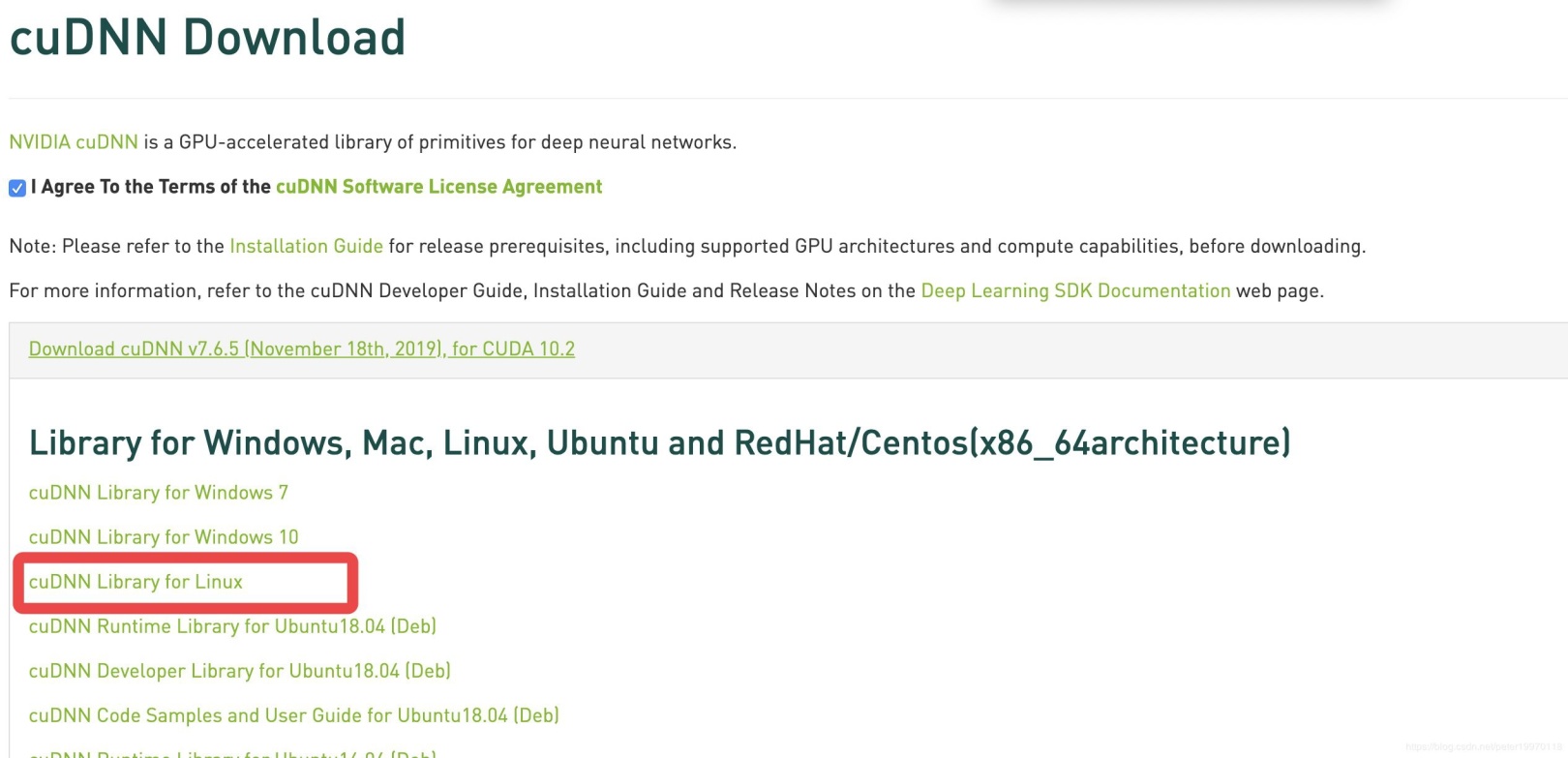

cuDNNを取得

公式ウェブサイトのリンクに登録してメールを確認したら、[cuDNNをダウンロード]をクリックしてダウンロードしてください

同意する前にチェックすることを忘れないでください〜

最新バージョンはCUDA10.2、cuDNN 7.6.5.32で、取得されるファイルは cudnn-10.2-linux-x64-v7.6.5.32.tgzです。

ダウンロードが完了したら、ダウンロードディレクトリに入り、次のコマンドを使用して解凍します

$ tar -zxvf cudnn-10.2-linux-x64-v7.6.5.32.tgz

cudaという名前のフォルダが生成されます。フォルダを入力してください

$ cd cuda

次に、コピー操作を使用してインストールを完了します

sudo cp lib64/libcudnn*/usr/local/cuda/lib64/

sudo cp include/cudnn.h /usr/local/cuda/include

操作が完了したら、cuDNNディレクトリに入り、ライブラリファイルのソフトリンクを更新します。

$ cd /usr/local/cuda/lib64

$ sudo chmod +r libcudnn.so.7.6.5

$ sudo ln -s libcudnn.so.7.6.5 libcudnn.so.7

$ sudo ln -s libcudnn.so.7.6.5 libcudnn.so

$ sudo ldconfig

ソフトリンク中にエラーが報告された場合は、-sを-sfに変更してください

次に、〜/ .bashrcに環境変数を追加します

export LD_LIBRARY_PATH=/usr/local/cuda-10.2/lib64:usr/local/cuda-10.2/extras/CUPTI/lib64:$LD_LIBRARY_PATH

export CUDA_HOME=/usr/local/cuda-10.2export PATH=/usr/local/cuda-10.2/bin:$PATH

この時点で、CUDAとcuDNNのインストールは完了です。

**5、正式にTensorFlow **のインストールを開始しました

インストールを開始する前に、まずpipをインストールします

$ sudo apt-get install python3-pip python3-dev

完了後、pipと入力し、Enterキーを押すと、関連するコマンドが出力されます

Usage:

pip <command [options]

pipのインストールが完了したら、次のコマンドを入力して最新のTensorFlowのインストールを開始します。

$ pip install tensorflow

GPUがない場合は、CPUバージョンのTensorFlowをインストールします

$ pip install tensorflow-cpu

インストール後、 Pythonを使用して最初のTensorFlowプログラムをテストします

$ python3

import tensorflow as tf

tf.add(1,2).numpy()3

hello = tf.constant('Hello, TensorFlow!')

hello.numpy()

b'Hello, TensorFlow!'

上記の結果が生成されると、TensorFlowは正常にインストールされます。

この時点で、TensorFlow使用環境、インストールは完了です。

これまで、UbuntuでTensorFlow使用環境を構成する方法に関するこの記事を紹介しました。関連するUbuntu構成TensorFlowコンテンツについては、ZaLou.Cnの以前の記事を検索するか、以下の関連記事を引き続き参照してください。今後、ZaLouをサポートしていただければ幸いです。 Cn!

Recommended Posts