Centos 7 RAID5の詳細な説明と構成

1. RAIDとは:

- ディスクアレイの正式名称は「安価なディスクの冗長アレイ、RAID」です。これは、耐障害性のある安価なディスクアレイを意味します。

- RAIDは、テクノロジー(ソフトウェアまたはハードウェア)を介して複数の小さなディスクを大きなディスクデバイスに統合できます。この大きなディスクの機能はストレージだけでなく、データ保護の機能も備えています。

- 選択したレベルが異なるため、RAID全体の機能が異なります。

1、 RAID-0(同等モード、ストライプ):最高のパフォーマンス

- このモードは、同じモデルと容量のディスクで構成されている場合に適しています。

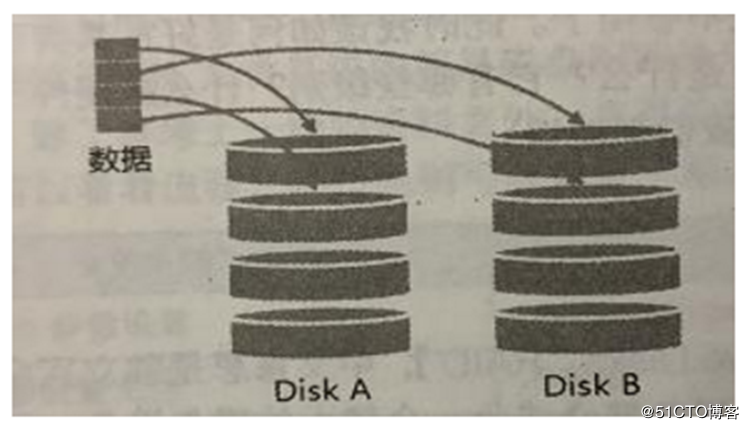

- このモードのRAIDでは、ディスクは最初に同じ量のブロック(名前付きチャンク、通常は4Kから1M)を切り取り、次にファイルをRAIDに書き込むときに、ファイルはチャンクのサイズに従って切り取られます。 、次にそれらを各ディスクに順番に配置します。

- 各ディスクはインターリーブされたデータを格納するため、データがRAIDに書き込まれると、データは各ディスクに同じ量で配置されます。

2、 RAID-1(マッピングモード、ミラー):完全バックアップ

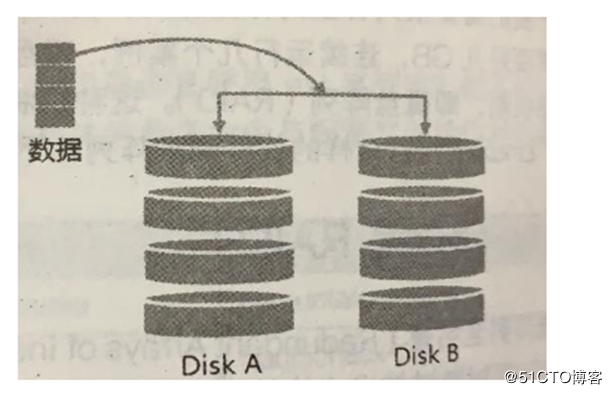

- このモードでも、同じディスク容量、できれば同じディスクが必要です。

- 異なる容量のディスクがRAID-1を形成する場合、合計容量は最小のディスクになります。このモードは、主に「2つのディスクに完全に保存されたデータの同じコピーを作成する」ためのものです。

- たとえば、100MBのファイルがあり、RAID-1を形成するディスクが2つしかない場合、2つのディスクは同時に100MBをストレージスペースに書き込みます。したがって、全体的なRAID容量はほぼ50%少なくなります。 2つのハードディスクの内容は、ミラーで反射されているかのようにまったく同じであるため、ミラーモードとも呼ばれます。

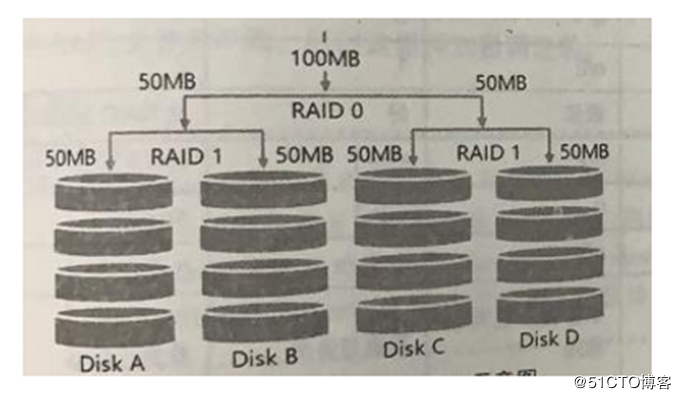

3、 RAID 1+0,RAID 0+1

- RAID-0のパフォーマンスは良好ですが、データは安全ではありません。RAID-1の[データセキュリティ](https://cloud.tencent.com/solution/data_protection?from=10680)ですが、パフォーマンスは良くありません。この2つを統合してRAIDをセットアップできますか?

- RAID 1 +0は次のとおりです。

(1)最初に2つのディスクがRAID 1を形成し、そのような設定には2つのグループがあります。

(2)RAID1のこれら2つのグループをRAID0のグループに結合します。これはRAID1 +0です - RAID 0 +1は次のとおりです。

(1)最初に2つのディスクがRAID 0を形成し、そのような設定には2つのグループがあります。

(2)これら2セットのRAID 0を組み合わせて、RAID1のセットを形成します。これはRAID0 +1です

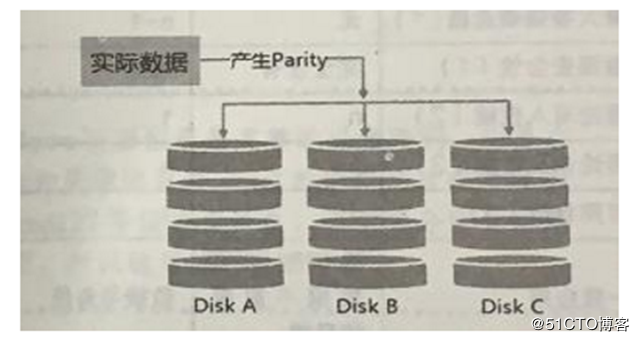

4、 RAID5:パフォーマンスとデータバックアップのバランスの考慮(強調)

- RAID-5では、このタイプのディスクアレイを形成するために少なくとも3つのディスクが必要です。

- このディスクアレイのデータ書き込みはRAID-0に少し似ていますが、書き込み(ストライピング)の各サイクル中に、パリティチェックデータ(パリティ)が各ディスクに追加され、このデータは他のディスクのバックアップデータを記録します、ディスクが損傷した場合の救助に使用されます。

RAID5はどのように機能しますか:

- 書き込みの各サイクル中に、パリティの一部が記録され、記録されたパリティは毎回異なるディスクに記録されるため、ディスクが損傷した場合、他のディスクから借りることができます。コードを確認して、元のディスクのデータを再構築してください。ただし、パリティチェックコードにより、RAID5の総容量はディスクの総数から1を引いた数になることに注意してください。

- 元の3つのディスクの容量は、(3-1)= 2ディスクのみです。

- 損傷したディスクの数が2以上になると、RAID5データ全体が破壊されます。 RAID 5は、デフォルトで1つのディスクの破棄しかサポートできないためです。

RAID6は2つのディスク損傷をサポートできます

スペアディスク(予約ディスク機能):

ハードディスクが破損したときにシステムをリアルタイムでアクティブに再構築するには、スペアディスクの支援が必要です。いわゆるスペアディスクは、元のディスクアレイレベルに含まれていない1つ以上のディスクです。このディスクは通常、ディスクアレイによって使用されません。ディスクアレイ内のいずれかのディスクが損傷すると、スペアディスクは率先してディスクアレイに引き込み、壊れたハードディスクをディスクアレイから移動します。次に、すぐにデータシステムを再構築します。

ディスクアレイの利点:

- データのセキュリティと信頼性:ネットワーク情報のセキュリティを意味するのではなく、ハードウェア(ディスクを参照)が損傷したときにデータを安全にレスキューまたは使用できるかどうかを意味します。

- 読み取りと書き込みのパフォーマンス:たとえば、RAID 0は読み取りと書き込みのパフォーマンスを向上させ、システムのI / O部分を改善できます。

- 容量:複数のディスクを組み合わせることができるため、1つのファイルシステムでかなりの容量を使用できます。

2.ソフトウェア、ハードウェアRAID:

.

**ディスクアレイがハードウェアとソフトウェアに分割されているのはなぜですか? ****

いわゆるハードウェアRAID(ハードウェアRAID)は、ディスクアレイカードを介してアレイの目的を達成します。ディスクアレイカードにはRAIDのタスクを処理するための特別なチップがあるので、パフォーマンスの点で優れています。多くのタスク(RAID 5のパリティ計算など)では、ディスクアレイが元のシステムのI / Oバスを繰り返し消費することはなく、理論的にはパフォーマンスが向上します。さらに、現在の一般的なハイエンドディスクアレイカードはホットスワップ可能をサポートしています。つまり、損傷したディスクをシャットダウンせずに交換できるため、システムの回復とデータの信頼性に非常に役立ちます。

ソフトウェアディスクアレイは、主にソフトウェアを介してアレイのタスクをシミュレートするためのものであるため、CPU操作やI / Oバスリソースなどのより多くのシステムリソースを消費します。しかし、私たちのパーソナルコンピュータはすでに非常に高速であるため、以前の速度制限はもう存在しません!

CentOSが提供するソフトウェアディスクアレイはmdadmソフトウェアです。このソフトウェアは、ディスクの単位としてパーティションまたはディスクを使用します。つまり、3つ以上のパーティション(パーティション)がある限り、3つ以上のディスクは必要ありません。ディスクアレイを設計できます。

さらに、mdadmは前述のRAID0 / RAID1 / RAID5 /スペアディスクをサポートします。さらに、提供されている管理メカニズムは、ホットスワッピングと同様の機能を実現でき、パーティションスワッピングはオンラインで実行できます(通常はファイルシステムが使用されます)。使い方もとても便利!

3.ソフトウェアディスクアレイの構成:

また、あまりにもしつこいので、ソフトウェアディスクアレイを構成しましょう。

おおよその手順:

- 4つのパーティションを使用してRAID5を形成します。

- 各パーティションのサイズは約1GBです。各パーティションが同じサイズであることを確認することをお勧めします。

- 1つのパーティションを使用して、スペアディスクチャンクを256Kに設定します。

- このスペアディスクのサイズは、他のRAIDに必要なパーティションと同じ大きさです。

- このRAID5デバイスを/ srv / raidディレクトリにマウントします

構成の開始:** 1、パーティション**

[ root@raid5 /]# gdisk /dev/sdb #gdiskコマンドを使用してパーティションを作成します。fdiskを使用することもできます

Command(?for help): n #新しいパーティションを追加します

Partition number(1-128,default1):1 #パーティション番号は1です

First sector(34-41943006,default=2048) or {+-}size{KMGTP}:

Last sector(2048-41943006,default=41943006) or {+-}size{KMGTP}:+1G #サイズは1Gです

Current type is 'Linux filesystem'

Hex code or GUID(L to show codes, Enter =8300): #GUID番号

Changed type of partition to 'Linux filesystem'

# 上記のコマンドに従って、4つのパーティションを作成します

Command(?for help): P #作成したパーティションを表示する

....................... //省略部分

Number Start(sector)End(sector) Size Code Name

1204820991991024.0 MiB 8300 Linux filesystem

2209920041963511024.0 MiB 8300 Linux filesystem

3419635262935031024.0 MiB 8300 Linux filesystem

4629350483906551024.0 MiB 8300 Linux filesystem

58390656104878071024.0 MiB 8300 Linux filesystem

# 保存して終了

[ root@raid5 /]# lsblk #ディスクリストを表示

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:00 100G 0 disk

├─sda1 8:10 1G 0 part /boot

└─sda2 8:20 99G 0 part

├─cl-root 253:00 50G 0 lvm /

├─cl-swap 253:10 2G 0 lvm [SWAP]

└─cl-home 253:20 47G 0 lvm /home

sdb 8:160 20G 0 disk #sdbディスクに4つのパーティションがあることを確認してください

├─sdb1 8:170 1G 0 part

├─sdb2 8:180 1G 0 part

├─sdb3 8:190 1G 0 part

└─sdb4 8:200 1G 0 part

└─sdb5 8:210 1G 0 part #5番目は予約済みディスクです

sr0 11:01 1024M 0 rom

2、 作成

[ root@raid5 /]# mdadm --create /dev/md0 --auto=yes --level=5--chunk=256K --raid-devices=4--spare-devices=1/dev/sdb1 /dev/sdb2 /dev/sdb3 /dev/sdb4 /dev/sdb5

mdadm: Defaulting to version 1.2 metadata

mdadm: array /dev/md0 started.--create:RAIDを作成するオプション

- - auto=はい:次のソフトウェアディスクアレイデバイス、つまりmdを作成することを決定します[0-9]--chunk=256K:このデバイスのチャンクサイズを決定します。これはストライプサイズとしても使用できます。通常は64Kまたは512Kです。

- - raid-devices=4:ディスクアレイデバイスとして複数のディスクまたはパーティションを使用する

- - spare-devices=1:バックアップデバイスとして複数のディスクまたはパーティションを使用する

- - level=5:このディスクアレイのグループのレベルを設定します。0、1、および5のみを使用することをお勧めします。

- - 詳細:背後に接続されているディスクアレイデバイスの詳細情報

[ root@raid5 /]# mdadm --detail /dev/md0

/dev/md0: #RAIDデバイスのファイル名

Version :1.2

Creation Time : Thu Nov 720:26:032019 #作成時間

Raid Level : raid5 #RAIDレベル

Array Size :3142656(3.00 GiB 3.22 GB) #RAID全体の利用可能な容量

Used Dev Size :1047552(1023.00 MiB 1072.69 MB) #各ディスクの容量

Raid Devices :4 #RAIDを構成するディスクの数

Total Devices :5 #スペアを含むディスクの総数

Persistence : Superblock is persistent

Update Time : Thu Nov 720:26:082019

State : clean #このディスクアレイの現在の使用状況

Active Devices :4 #開始したデバイスの数

Working Devices :5 #このアレイで現在使用されているデバイスの数

Failed Devices :0 #破損したデバイスの数

Spare Devices :1 #予約済みディスクの数

Layout : left-symmetric

Chunk Size : 256K #これはチャンクの小さなブロック容量です

Name : raid5:0(local to host raid5)

UUID : facfa60d:c92b4ced:3f519b65:d135fd98

Events :18

Number Major Minor RaidDevice State

08170 active sync /dev/sdb1

18181 active sync /dev/sdb2

28192 active sync /dev/sdb3

58203 active sync /dev/sdb4

4821- spare /dev/sdb5 #ステージング領域のバックアップデバイスとしてsdb5を参照してください

# 最後の5行は、これら5つのデバイスの現在のステータスです。RaidDeviceは、このRaidのディスク順序を示します。

[ root@raid5 /]# cat /proc/mdstat

Personalities :[raid6][raid5][raid4]

md0 : active raid5 sdb4[5] sdb5[4](S) sdb3[2] sdb2[1] sdb1[0] #最初の行

3142656 blocks super1.2 level 5, 512k chunk, algorithm 2[4/4][UUUU] #二行目

unused devices:<none>

最初の行の部分:md0がraid5であり、sdb1、sdb2、sdb3、sdb4などの4つのディスクデバイスが使用されていることを示します。各デバイスの後の括弧[]内の数字は、RAID(RaidDevice)内のディスクの順序です。sdb5の後の[S]は、sdb5がスペアであることを意味します。

2行目:このディスクアレイには3142656ブロック(各ブロックユニットは1K)があるため、RAID 5レベルを使用すると、合計容量は約3GBになり、アルゴリズム2ディスクを使用すると、ディスクに書き込まれる小さなブロック(チャンク)のサイズは256Kになります。アレイアルゴリズム。 [m / n]は、このアレイにm個のデバイスが必要であり、n個のデバイスが正常に動作していることを意味します。したがって、このmd0には4つのデバイスが必要であり、4つのデバイスすべてが正常に動作しています。次の[UUUU]は、必要な4つのデバイスの起動ステータス(つまり、[m / n]のm)を表し、Uは正常な動作を表し、_の場合は異常を表します。

3、 使用するフォーマットとマウント

[ root@raid5 /]# mkfs.xfs -f -d su=256k,sw=3-r extsize=768k /dev/md0 #このフォーマットはmd0であることに注意してください

meta-data=/dev/md0 isize=512 agcount=8, agsize=98176 blks

= sectsz=512 attr=2, projid32bit=1= crc=1 finobt=0, sparse=0

data = bsize=4096 blocks=785408, imaxpct=25= sunit=128 swidth=384 blks

naming =version 2 bsize=4096 ascii-ci=0 ftype=1

log =internal log bsize=4096 blocks=2560, version=2= sectsz=512 sunit=8 blks, lazy-count=1

realtime =none extsz=1572864 blocks=0, rtextents=0[root@raid5 /]# mkdir /srv/raid

[ root@raid5 /]# mount /dev/md0 /srv/raid/[root@raid5 /]# df -TH /srv/raid/ #正常にマウントされたことを確認してください

Filesystem Type Size Used Avail Use% Mounted on

/dev/md0 xfs 3.3G 34M 3.2G 2%/srv/raid

4、 シミュレーションRAIDエラーレスキュー

言われているように、「空では予測できないことが起こり、人々は幸運に恵まれます。」ディスクアレイの機器がいつ故障するかは誰にもわからないので、ソフトウェアディスクアレイの救済を理解する必要があります。 RAIDエラーを模倣してレスキューしましょう。

[ root@raid5 /]# cp -a /var/log//srv/raid/ #最初にいくつかのデータをマウントポイントにコピーします

[ root@raid5 /]# df -TH /srv/raid/; du -sm /srv/raid/* #内部にすでにデータがあることを確認してください

Filesystem Type Size Used Avail Use% Mounted on

/dev/md0 xfs 3.3G 39M 3.2G 2% /srv/raid

5 /srv/raid/log

[ root@raid5 /]# mdadm --manage /dev/md0 --fail /dev/sdb3

mdadm: set /dev/sdb3 faulty in /dev/md0 #ディスプレイが間違ったデバイスになりました

.............................. //コンテンツの一部を省略

Update Time : Thu Nov 7 20:55:31 2019

State : clean

Active Devices : 4

Working Devices : 4

Failed Devices : 1 #ディスクエラー

Spare Devices : 0 #ここでの準備は0になり、ジョブが置き換えられたことを示しています。ここでのインターセプトは少し遅いですが、それ以外の場合は1のままです。

............................ //コンテンツの一部を省略

Number Major Minor RaidDevice State

0 8 17 0 active sync /dev/sdb1

1 8 18 1 active sync /dev/sdb2

4 8 21 2 active sync /dev/sdb5 #ここでは、sdb5が作業に取って代わったことがわかります

5 8 20 3 active sync /dev/sdb4

2 8 19 - faulty /dev/sdb3 #sdb3は死んでいます

次に、不良ディスクを取り外して、新しいディスクと交換できます

[ root@raid5 /]# mdadm --manage /dev/md0 --remove /dev/sdb3 #古いディスクのプラグを抜くシミュレーション

mdadm: hot removed /dev/sdb3 from/dev/md0

[ root@raid5 /]# mdadm --manage /dev/md0 --add /dev/sdb3 #新しいディスクを挿入します

mdadm: added /dev/sdb3

[ root@raid5 /]# mdadm --detail /dev/md0 #見る

........................... //コンテンツの一部を省略

Number Major Minor RaidDevice State

08170 active sync /dev/sdb1

18181 active sync /dev/sdb2

48212 active sync /dev/sdb5

58203 active sync /dev/sdb4

6819- spare /dev/sdb3 #sdb3がスペアディスクとしてここで待機していることがわかります

5、 起動RAIDを設定し、自動的にマウントします

[ root@raid5 /]# mdadm --detail /dev/md0 | grep -i uuid

UUID : facfa60d:c92b4ced:3f519b65:d135fd98

[ root@raid5 /]# vim /etc/mdadm.conf

ARRAY /dev/md0 UUID=facfa60d:c92b4ced:3f519b65:d135fd98

# RAIDデバイス識別コードの内容

[ root@raid5 /]# blkid /dev/md0

/dev/md0: UUID="bc2a589c-7df0-453c-b971-1c2c74c39075" TYPE="xfs"[root@raid5 /]# vim /etc/fstab #自動マウントを設定する

............................ //コンテンツの一部を省略/dev/md0 /srv/raid xfs defaults 00

# 冒頭はUUIDとして入力することもできます

[ root@raid5 /]# df -Th /srv/raid/ #再起動テストを実行できます

Filesystem Type Size Used Avail Use% Mounted on

/dev/md0 xfs 3.0G 37M 3.0G 2%/srv/raid

Recommended Posts